保險運維日志管理與日志分析項目是保障保險公司信息系統穩定運行、提升運維效率與風險管理能力的重要舉措。以下是完整的系統方案設計思路及具體設計內容,重點介紹數據處理服務部分。

一、系統總體設計

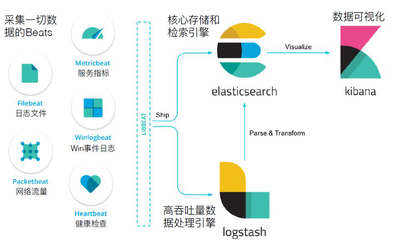

保險運維日志管理系統通常采用分層架構:數據采集層、數據處理層、數據存儲層和應用分析層。整體方案需滿足高可用性、可擴展性和安全性要求,支持實時與批量處理,并符合保險行業監管規定。

二、具體設計內容

- 數據采集設計

- 日志源識別:涵蓋應用系統、網絡設備、數據庫、安全設備及云平臺日志

- 采集方式:支持Agent、API接口、Syslog等多種方式

- 日志標準化:定義統一的日志格式規范

- 數據處理服務設計(核心部分)

- 數據解析:通過正則表達式、GroK模式等技術解析非結構化日志

- 數據清洗:過濾無效數據、去重、補全缺失字段

- 數據分類:按業務類型(承保、理賠、財務等)和級別(ERROR、WARN、INFO)分類

- 數據增強:關聯業務上下文,添加地理信息、用戶標簽等元數據

- 實時處理:使用流處理技術(如Flink、Spark Streaming)實現異常實時告警

- 批量處理:通過ETL工具定期處理歷史數據,支持離線分析

- 數據存儲設計

- 熱數據存儲:采用Elasticsearch等搜索引擎,支持快速查詢

- 冷數據存儲:使用HDFS或數據倉庫進行長期歸檔

- 數據索引:建立多維度索引(時間、業務類型、嚴重程度等)

- 分析應用設計

- 可視化展示:通過儀表盤展示系統健康度、業務趨勢等

- 智能分析:應用機器學習算法進行異常檢測、根因分析

- 告警管理:配置閾值告警、智能預測告警

- 安全與合規設計

- 訪問控制:基于角色的權限管理

- 審計追蹤:記錄所有日志訪問操作

- 數據加密:傳輸和存儲過程中的數據加密

三、數據處理服務關鍵技術選型

建議采用分布式處理框架(如Spark、Flink),結合消息隊列(Kafka)實現數據緩沖,使用日志解析庫(如Logstash)進行格式轉換,并通過規則引擎實現智能分類。

本方案通過完善的數據處理服務設計,能夠幫助保險公司實現運維日志的全生命周期管理,提升系統穩定性,支持業務決策,并滿足監管合規要求。